Piste

Dans un tweet publié ce matin, la société d’intelligence artificielle Runway taquiné une nouvelle fonctionnalité de son site Web alimenté par l’IA Editeur de vidéo qui peut éditer une vidéo à partir de descriptions écrites, souvent appelées “invites”. Une vidéo promotionnelle semble montrer les toutes premières étapes vers le montage ou la génération de vidéos commerciales, faisant écho au battage médiatique sur les récents modèles de synthèse texte-image tels que Diffusion stable mais avec un cadrage optimiste pour couvrir les limitations actuelles.

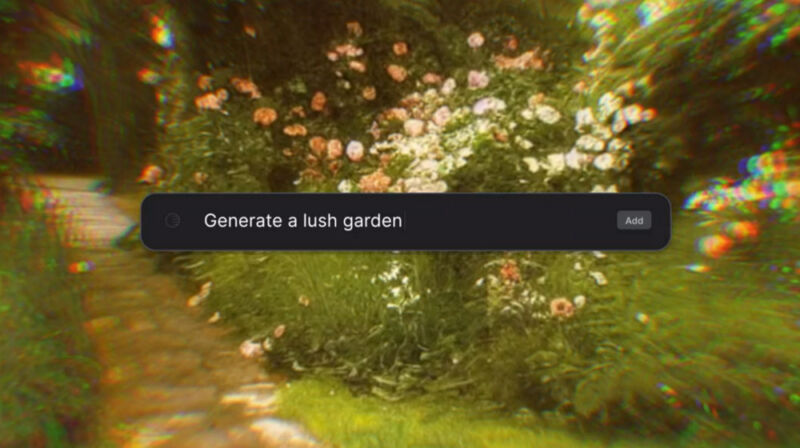

La bobine de démonstration “Text to Video” de Runway montre une zone de saisie de texte qui permet d’éditer des commandes telles que “importer la rue de la ville” (suggérant que le clip vidéo existait déjà) ou “rendre le clip plus cinématographique” (en appliquant un effet). Il représente quelqu’un tapant “supprimer l’objet” et sélectionnant un lampadaire avec un outil de dessin qui disparaît ensuite (d’après nos tests, Runway peut déjà effectuer un effet similaire en utilisant son outil “inpainting”, avec des résultats mitigés). La vidéo promotionnelle présente également ce qui ressemble à une génération de texte à image d’image fixe similaire à Stable Diffusion (notez que la vidéo ne représente aucune de ces scènes générées en mouvement) et montre la superposition de texte, le masquage de caractères (à l’aide de son “écran vert ” fonctionnalité, également déjà présente dans Runway), et plus encore.

Les promesses de génération vidéo mises à part, ce qui semble le plus nouveau dans l’annonce Text to Video de Runway est l’interface de commande basée sur le texte. Reste à savoir si les éditeurs vidéo voudront travailler avec des invites en langage naturel à l’avenir, mais la démonstration montre que les acteurs de l’industrie de la production vidéo travaillent activement vers un avenir dans lequel synthétiser ou éditer une vidéo est aussi simple que d’écrire une commande.

Ars Technica

La génération vidéo brute basée sur l’IA (parfois appelée “text2video”) est dans un état primitif en raison de ses exigences de calcul élevées et de l’absence d’un grand ensemble de formation vidéo ouvert avec des métadonnées qui peuvent former des modèles de génération vidéo équivalents à LAION-5B pour les images fixes. L’un des modèles text2video publics les plus prometteurs, appelé CogVidéo, peut générer des vidéos simples en basse résolution avec des fréquences d’images saccadées. Mais compte tenu de l’état primitif des modèles texte-image il y a tout juste un an contre aujourd’huiil semble raisonnable de s’attendre à ce que la qualité de la génération de vidéo synthétique augmente à pas de géant au cours des prochaines années.

Runway est disponible en tant que produit commercial basé sur le Web qui s’exécute dans le navigateur Google Chrome moyennant des frais mensuels, ce qui inclut le stockage dans le cloud pour environ 35 $ par année. Mais la fonctionnalité Text to Video est en cours de test “Early Access” fermé, et vous pouvez vous inscrire à la liste d’attente sur Site Web de la piste.